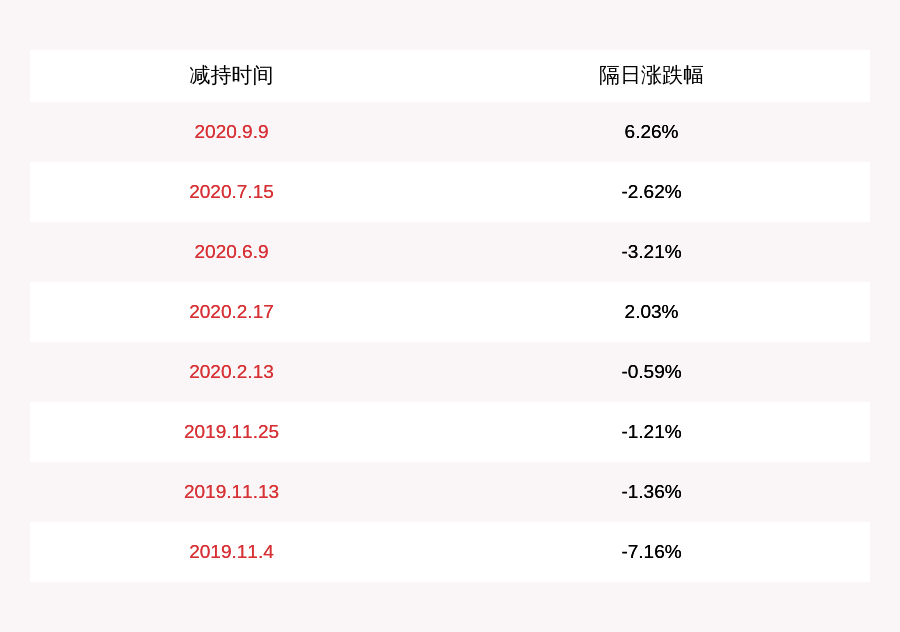

NVIDIA|不是GPU的IPU:NVIDIA要小心了( 三 )

Graphcore高级副总裁兼中国区总经理卢涛说:“现在一些全球领先的研究 , 像NLP方面 , 大家开始来探索一些像sparse NLP的算法模型 。我们的技术对很多超大规模的AI模型非常有帮助 。”

文章图片

通信

通信也是目前数据中心大规模计算非常关键的问题 。为此 , Graphcore专为为AI横向扩展设计了IPU-Fabric 。IPU-Fabric可以做到2.8Tbps超低延时的结构 , 同时最多可以支持64000个IPU之间的横向扩展 。

卢涛介绍 , IPU-Fabric是由三种网络一起组成 , 第一种是IPU-Link , 第二种叫IPU Gateway Link , 第三种是IPU over Fabric 。IPU-Link是在一个机架(rack)之内提供在IPU之间的一个通讯的接口 。IPU Gateway Link提供了机架和机架之间横向扩展之间的网络 。IPU over Fabric能够把IPU的集群和x86的集群进行非常灵活以及低延时、高性能组合起来的网络 。

文章图片

将计算、数据、通信的突破结合在一起 , 就可以用于构建大规模可扩展的IPU-POD系统 。一个用于超算规模的IPU-POD的形态是一个IPU-POD64 , 这是IPU-POD的一个基本组件 , 每个IPU-POD64的机柜里面总共有64颗IPU , 提供16PFlops的算力、58GB的In-Processor-Memory , 总共达到了7个TB的流存储 。

文章图片

因此 , 在IPU-POD中间非常重要的是把AI的计算跟逻辑的控制进行了解耦 , 让系统易于部署 , 网络延时非常低 , 能够支持非常大型的一个算法模型 , 以及非常安全的多住户的使用 。

卢涛表示 , “IPU-Fabric最高支持64000个IPU-POD组成的集群 , 总共能提供16 EFlops FP16的算力 。日本前一阵发布的超算是0.5 EFlops算力 。而我们基于64000个IPU总共可以组建16个EFlops算力 , 这非常惊人 。”

Graphcore为什么值得NVIDIA关注?

“目前超大规模IPU-POD技术主要的应用场景还是大规模AI训练 , 包括自然语言处理以及机器视觉的应用 , IPU-POD都有优势 。”卢涛指出 , “譬如说做一个模型的训练 , GPU的性能是1 , 可能一个单机有8张卡 , 性能比0.7高 。但如果把场景扩展到1000个GPU或者几千个GPU , 性能可能会下降到0.7、0.6 , 好一点可能到0.8 , 而超大规模的IPU-POD很重要的是要帮助大家解决大规模集群可扩展性的问题 。

另外 , 从功耗的角度看 , 不同的场景会有一些差别 。总体来看 , 单片 M2000 的整机系统功耗为 1.1KW , 折合到每颗IPU处理器的性能功耗比 0.9TFlops/W , 在同类面向数据中心高性能AI计算的产品中 , 比A100 GPU的0.7TFlops/W , 华为Ascend 910的 0.71TFlops/W的能效比都高一些 。

也就是说 , 在大规模数据中心 , Graphcore将会与NVIDIA进行正面的竞争 。雷锋网认为 , 相比于来自类GPU的竞争 , NVIDIA不应该忽视Graphcore的IPU , 特别是Graphcore一直都在强调其是为AI而生 , 面向的应用也是CPU、GPU不那么擅长的AI应用 。

推荐阅读

- 潇湘晨报|求归还被拒!上海一老总错转21万欲哭无泪:怎么证明我真不是骗子

- 芯片|气候异常!东北半个月遭台风三连击,分析:短期长期都不是好事

- 趣头条|号称能“放松肌肉”“减肥瘦身”的网红筋膜枪,是不是智商税?

- 微微一笑很凑合|你是不是藏了私房钱

- 日本|美国突然醒悟,最大的对手不是俄罗斯,德专家:不阻止就来不及了

- 孙冾讲娱乐|颜值高身材好的妹子是不是都在手机上?,搞笑GIF:我就想问问

- 穿搭|不想穿彩色衣服?也不是不可以,这样穿就很高级

- 电视剧杂谈|个子不是很高的女人,日常穿衣记住3个公式,让自己更加高挑年青

- 车行生活|06 恐怕只有一个理由——你老了,拒绝领克

- 宁宁育儿|你可知第一个女皇帝是谁吗,武则天并不是第一个女皇帝